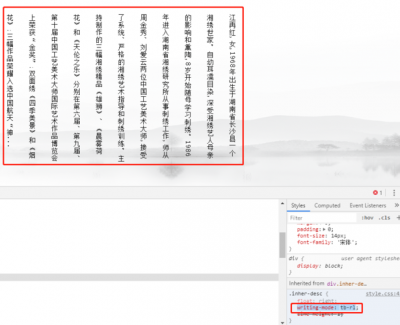

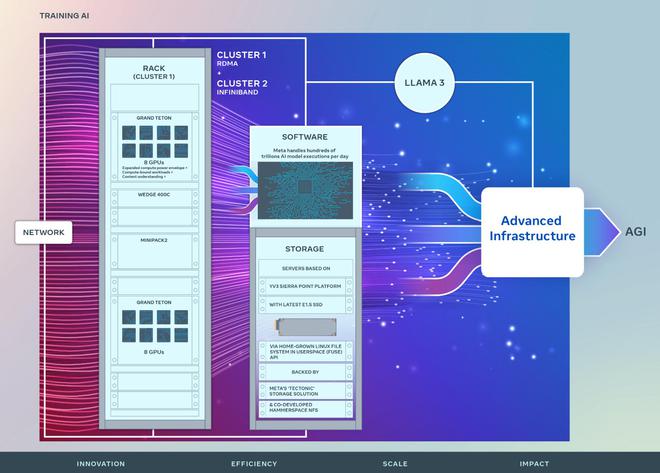

3 月 13 日消息,美国时间周二,Facebook 母公司 Meta 公布了两个数据中心规模新集群的技术细节,它们各自拥有超过 2.4 万个 GPU,并在硬件、网络、存储、设计、性能和软件等方面上,专为支持大型语言模型如 Llama 3 进行训练而深度优化。

这两个新集群基于 Meta 先前研究超级集群(RSC)的成功。RSC 自 2022 年启用以来,已展现出强大的计算力。

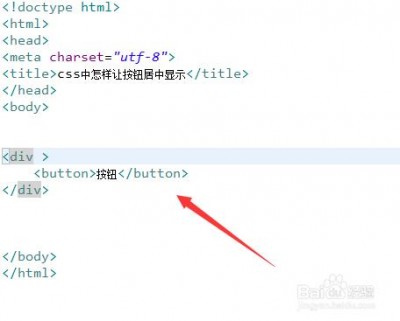

在硬件配置方面,每个集群都配备了 24576 个英伟达 Tensor Core H100 GPU(每个数万美元),与之前使用的 16000 个英伟达 A100 GPU 相比有了明显提升,这将极大地促进自然语言处理、语音识别和图像生成等人工智能研究和开发工作。

Meta 表示,这种升级不仅在数量上有所增加,其性能上的跃进也将支持更大、更复杂的模型,为生成式人工智能产品的开发铺平道路。

Meta 计划在 2024 年底之前,将其人工智能基础设施扩大到高达 35 万个 H100 GPU。目标是拥有相当于近 60 万个 H100 GPU 的算力。

图片来源:Meta 官方博客

虽然两个新集群的 GPU 数量相同,但它们在网络基础设施方面各有差异,均支持 400 Gbps 端点之间的互联。其中一个集群采用了基于 Arista 7800 交换机配合 Wedge400 和 Minipack2 OCP 机架交换机的远程直接内存访问(RDMA)和融合以太网(RoCE)网络解决方案,而另一个则应用了英伟达 Quantum2 InfiniBand 网络架构。

值得一提的是,两个集群均基于 Meta 自研的开放 GPU 硬件平台 Grand Teton 构建,这是公司为支撑大型 AI 工作负载而开发的 GPU 基础硬件平台。作为 Zion-EX 平台的后续产品,Grand Teton 在主机到 GPU 的带宽、计算及数据网络带宽、以及功率包络等方面都实现了显著的增强。

此外,这些集群充分利用了 Meta 专为 Grand Teton 等方案设计的 Open Rack 电源和机架架构,提高了数据中心的灵活性。

Meta 的 Open Rack v3 硬件设计引入了一个灵活的机架配置方案。与传统的固定母线设计相比,它允许在机架中的任意位置安装电源架,从而使机架配置更加灵活。

在建设这些新集群时,Meta 特别关注了每台服务器吞吐量、机架数量减少及能源效率之间的平衡。通过对机架内服务器数量的定制化设计,Meta 确保了这些集群在提供高性能的同时,也达到了能源的高效利用。

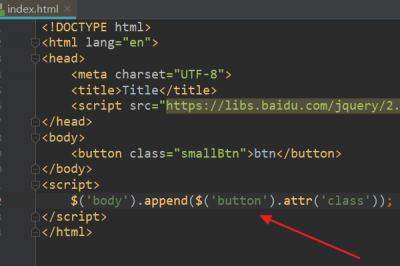

在存储技术上,这些集群运用了 Linux Filesystem 中的 Userspace API,并得到了 Meta 自家 Tectonic 分布式存储方案的加持。与此同时,Meta 还与 Hammerspace 合作,一道开发了并行网络文件系统(NFS)。

两个集群均基于配备了最新高容量 E1.S SSD 的 YV3 Sierra Point 服务器平台。为了优化网络利用率,Meta 进行了网络拓扑和路由的调整,并部署了英伟达的集体通信库(NCCL)。NCCL 是一套针对英伟达 GPU 和网络进行优化的标准通信例程库。

Meta 还在积极推进其 PyTorch 基础 AI 框架的发展,以应对数十万 GPU 的训练需求。Meta 的技术项目经理凯文·李(Kevin Lee)、生产网络工程师阿迪·甘吉迪(Adi Gangidi)以及生产工程总监马修·奥尔德姆(Mathew Oldham)在最新博客中共同表达了公司的技术愿景和战略。他们强调,Meta 将致力于人工智能软件和硬件的开放式创新,启动人工智能联盟,建立一个开放的生态系统,“为人工智能开发带来透明度、审查和信任,并带来每个人都能从中受益的创新,这些创新以安全和责任为首要考虑因素”。

这篇博文继续强调:“面对未来,我们意识到昨天和今天有效的方法可能无法满足明天的需求。因此,Meta 将不断评估和改进其基础设施的各个方面,从物理和虚拟层到软件层等。我们的目标是创建一个既灵活又可靠的系统,以支撑快速发展中的新模型和研究工作。”(小小)